本文介绍了“编写python爬虫的三种方法是什么?”很多人在实际案例的操作中会遇到这样的困难。接下来,让边肖带领大家学习如何应对这些情况!希望大家认真阅读,学点东西!

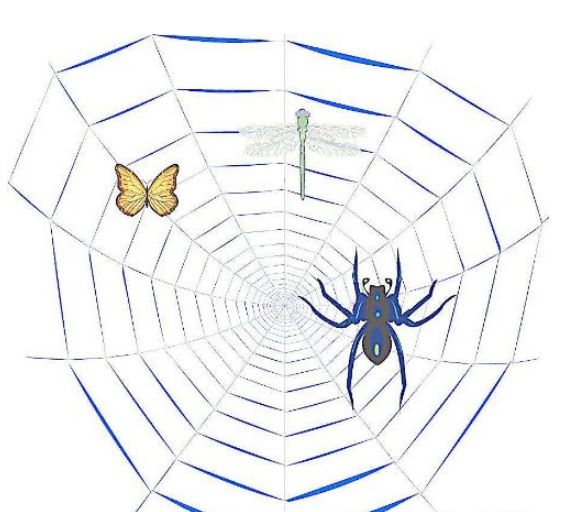

00-1010如果我们把互联网比作一个大蜘蛛网,数据存储在蜘蛛网的每个节点,爬虫就是一个小蜘蛛。

沿着网络抓取猎物(数据)的爬虫是指:向网站发出请求,获取资源后分析提取有用数据的程序;

从技术上讲,就是模拟浏览器通过程序请求站点的行为,将站点返回的HTML代码/JSON数据/二进制数据(图片、视频)爬上本地,然后提取自己需要的数据存储起来使用。

爬虫是什么?

用户获取网络数据的方式:

方法1:浏览器提交请求——下载网页代码——并将其解析为页面。

方法2:模拟浏览器发送请求(获取网页代码)-提取有用的数据-将其存储在数据库或文件中。

爬虫要做的是模式2;

1、发起请求

使用http库向目标站点发出请求,即发送请求。

请求包括:请求头、请求体等。

请求模块缺陷:无法执行JS和CSS代码

2、获取响应内容

如果服务器能够正常响应,就会得到响应。

回应包括:html、json、图片、视频等。

3、解析内容

解析html数据:正则表达式(RE模块),第三方解析库,如Beautifulsoup、pyquery等。

解析json数据:json模块

解析后的二进制数据:以wb模式写入文件。

4、保存数据

数据库(MySQL、Mongdb、Redis)

文件

这里介绍一下“编写python爬虫的三种方法是什么”的内容。感谢您的阅读。如果你想了解更多的行业,可以关注网站。边肖将为您输出更多高质量的实用文章!

内容来源网络,如有侵权,联系删除,本文地址:https://www.230890.com/zhan/123907.html