本文主要介绍Python线性回归分析。日常操作中,相信很多人对Python线性回归分析有所怀疑。边肖查阅了各种资料,整理出简单易用的操作方法,希望能帮你解答Python线性回归分析的疑惑!接下来,请和边肖一起学习!

线性回归

线性回归是机器学习和统计学中最基本、应用最广泛的模型,是对自变量和因变量之间的关系进行建模的回归分析。

代码概述

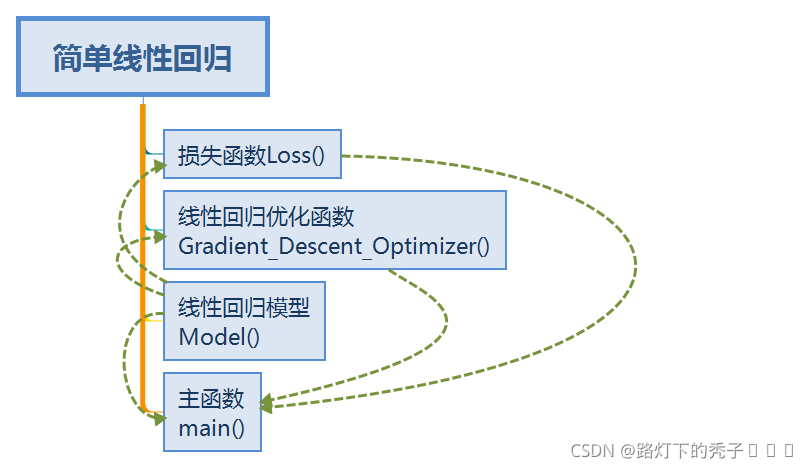

这次实现的线性回归是单变量的简单线性回归,模型包含两个参数,变系数W和偏移q。

训练数据是你自己用随机数生成的100个随机数据,存储在一个数组中。模型训练采用分批梯度下降法,损失函数采用平方损失函数。

上图展示了整个程序的函数调用关系。

在下面发布代码:

# includestdio.h

# includestdlib.h

#includemath.h

#includetime.h

doublew,q;

intm

//模型

浮点模型(浮点)

{

漂浮;

y=x * w q;

returny

}

//损失函数

doubleLoss(浮点*y,浮点*x)

{

double l=0;

//循环参数

inti,j,k;

for(I=0;im;(一)

{

L=(功率((y[I]-型号(x[i])),2))/(2 * m);

}

returnL

}

//梯度下降优化函数

空隙梯度下降优化器(浮动*x,浮动*y,浮动)

{

intj,I;

doubleQ=0,W=0;

for(I=0;im;(一)

W=x[i]*(型号(x[I])-y[I]);

W=W/m;

for(j=0;JM;j)

q=Model(x[j])-y[j];

Q=Q/m;

printf('W:%f\nQ:%f\n ',W,Q);

W=W-a * W;

Q=Q-a * Q;

}

//主要功能;培训过程

intmain()

{

//周期标志

inti,j;

//培训轮次

intepoch

//损失函数

doubleL

//学习率

漂浮;

floatx[100],y[100];

//随机数生成

for(I=0;i100(一)

{

x[I]=0.1 * I;

y[I]=x[I]* 3 ^ 5;//((rand())/10);

printf('X:%.2f,Y:%.2f\n ',x[i],y[I]);

}

//超参数设置

m=100

a=0.05

epoch=1000

//参数初始化

w=2;

q=3;

for(j=0;jepochj)

{

Gradient_Descent_Optimizer(x, y, a);

L = Loss(y, x);

printf("训练轮次:%d,损失:%f,参数w的值:%lf,参数q的值:%lf\n", j+1, L, w, q);

}

printf("最终值:\nw:%lf\nq:%lf\n", w, q);

system("pause");

}

问题总结

下面对在编写过程中需要注意的问题进行总结:

1.参数更新

模型中的参数需要同步更新。所有参数的更新值经过梯度下降法计算得出后要在最后同时更新所有参数。

2.保留损失函数

在代码编写过程中自己认为不用单独写一个损失函数,只需在梯度下降的过程中利用求导后的公式进行相关的参数优化操作即可,但在运行没有算是函数的程序时,没有实时的损失函数结果评估模型训练效果可能会导致模型在错误的道路上越走越远。

3.注意数据类型

初次运行程序,在训练至十几轮时参数就不再变化,一直到第1000轮参数都保持不变。后来在检查代码时发现,在优化函数将一些参数的数据类型错误设置为整型。因此当参数值改变程度小于1时,参数将不再变化。

4.超参数的设置及参数的初始化

学习率,训练轮次等的设置是一个对程序编写者经验要求比较高的工作,需要多次尝试,找到合适的值,参数的初始化也是这样。

心得

本次只是实现了简单线性回归的最基本的功能,同时也试一下自己刚买的机械键盘(用起来真的很舒服)。这只是我用来练手的程序,如果真的要编写程序实现功能还是推荐使用python语言搭配TensorFlow、Pytorch等深度学习平台实现自己想要的功能。程序的可完善空间非常大,比如数据和模型的可视化,将数据和模型的训练效果直观的展示出来,后面还会有序的用C语言实现诸如多元线性回归,二分类问题,多分类问题甚至卷积神经网络等等。我会在下面贴出使用Python语言编写的线性回归的程序,可以两者结合起来比较一下异同。

# -*- coding: utf-8 -*-

"""

Spyder Editor

This is a temporary script file.

"""

import matplotlib.pyplot as plt

import tensorflow as tf

import numpy as np

np.random.seed(5)

x_data = np.linspace(-1,1,100)

y_data = 2 * x_data + 1.0 + np.random.randn(*x_data.shape) * 0.4

np.random.randn(10)

#x_data.shape

#np.random.randn(*x_data.shape)

#np.random.randn(100)

plt.scatter(x_data,y_data)

plt.plot(x_data, 2 * x_data + 1.0, color = 'red',linewidth=3)

x = tf.placeholder("float",name="x")

y = tf.placeholder("float",name="y")

def model(x,w,b):

return tf.multiply(x,w)+b

w = tf.Variable(1.0,name="w0")

b = tf.Variable(0.0,name="b0")

pred = model(x,w,b)

train_epochs = 10

learning_rate = 0.05

loss_function = tf.reduce_mean(tf.square(y-pred))

optimizer = tf.train.GradientDescentOptimizer(learning_rate).minimize(loss_function)

sess = tf.Session()

init = tf.global_variables_initializer()

sess.run(init)

i_ci=0

for epoch in range(train_epochs):

for xs,ys in zip(x_data,y_data):

_, loss=sess.run([optimizer,loss_function],feed_dict={x:xs,y:ys})

b0temp=b.eval(session=sess)

w0temp=w.eval(session=sess)

plt.plot(x_data,w0temp*x_data+b0temp)

print("w:",sess.run(w))

print("b:",sess.run(b))

plt.scatter(x_data,y_data,label='Original data')

plt.plot(x_data,x_data*sess.run(w)+sess.run(b),label='Fitted Line',color='r',linewidth=3)

plt.legend(loc=2)

到此,关于“Python线性回归分析”的学习就结束了,希望能够解决大家的疑惑。理论与实践的搭配能更好的帮助大家学习,快去试试吧!若想继续学习更多相关知识,请继续关注网站,小编会继续努力为大家带来更多实用的文章!

内容来源网络,如有侵权,联系删除,本文地址:https://www.230890.com/zhan/77887.html